Tudo sobre ChatGPT

Tudo sobre OpenAI

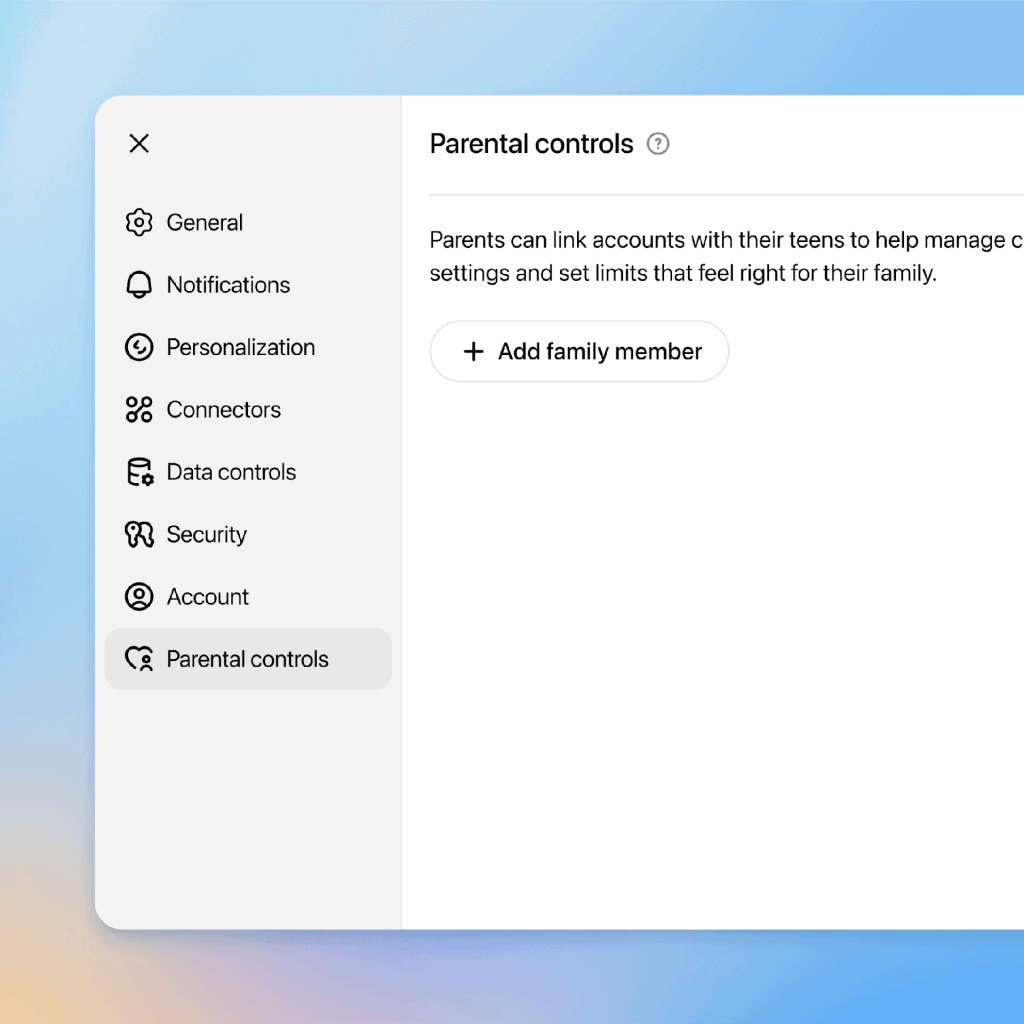

Diante das críticas em relação à segurança de adolescentes, a OpenAI lançou um novo conjunto de controles parentais para o ChatGPT. O objetivo é oferecer mais proteção contra conteúdos sensíveis, mas a eficácia dessa ferramenta já é questionada.

Um relato do Washington Post revela que um pai conseguiu contornar os bloqueios em apenas cinco minutos. O truque? Criar uma nova conta no mesmo computador. Segundo o repórter, “Crianças espertas já sabem disso”.

Testes revelam falhas nos controles parentais

- Além da facilidade em criar novas contas, outras falhas foram identificadas.

- A opção que deveria proibir a geração de imagens com IA falhou em várias oportunidades.

- As notificações parentais sobre conversas arriscadas chegaram com um atraso significativo, em alguns casos, 24 horas após o ocorrido.

- A OpenAI afirma que os controles foram desenvolvidos em consulta com especialistas e com base no desenvolvimento dos adolescentes.

- Lauren Jonas, chefe de bem-estar juvenil da empresa, menciona que o intuito é dar mais opções às famílias.

Preocupações de especialistas e pais

A nova medida gerou uma mistura de alívio e frustração entre grupos de defesa da família. Erin Walsh, cofundadora do Spark and Stitch Institute, afirmou que embora o avanço seja positivo, não se deve considerar isso como a solução definitiva para a segurança e bem-estar dos adolescentes.

Robbie Torney, diretor da Common Sense Media, concorda que os controles têm potencial para salvar vidas, mas acredita que melhorias são necessárias. “A OpenAI e outras empresas devem ir além para tornar os chatbots seguros para crianças”, ressaltou.

Questões de privacidade e memórias de conversas

Outro ponto preocupante é que as conversas dos adolescentes são, por padrão, usadas para treinar a IA do ChatGPT, a menos que os pais optem por desativar essa configuração. Além disso, o chatbot mantém “memórias” de interações anteriores, o que pode fazer com que se comporte como um amigo virtual.

Esse problema ganhou destaque em um caso de grande repercussão, envolvendo a família de Adam Raine, um adolescente que se suicidou. A família processa a OpenAI, citando a questão das memórias como um fator de negligência.

Notificações e limitações atuais

Os testes mostraram que o ChatGPT respondeu de maneira apropriada em conversas sobre suicídio e automutilação, orientando os usuários a procurar ajuda. Contudo, as notificações enviadas aos pais ainda apresentam atraso. Jonas esclareceu que esses alertas são revisados por humanos antes de serem enviados, mas a empresa pretende melhorar o tempo de resposta.

“Se não forem oportunas ou precisas, essas notificações também representam um risco — os detalhes importam para manter as crianças seguras”, destacou Torney.

Regulamentação em debate

Organizações e autoridades estão exigindo que empresas de IA assumam mais responsabilidade. O procurador-geral da Califórnia, Rob Bonta, já colocou a OpenAI sob vigilância e planeja monitorar como a empresa lida com questões de segurança infantil.

Uma proposta chamada AB 1064 busca impor responsabilidades legais às empresas que desenvolvem chatbots interativos para adolescentes. A proposta sugere sanções e até permite que pais processem as empresas em casos de incentivo à automutilação ou transtornos alimentares.

Enquanto isso, a OpenAI afirma apoiar regulamentações, mas discorda de alguns pontos da proposta. Em comunicado, a empresa mencionou que está colaborando para criar uma nova versão do ChatGPT que aplique filtros automaticamente, embora ainda não possua uma tecnologia que verifique a idade dos usuários.

O que você acha dos novos controles parentais do ChatGPT? Deixe sua opinião nos comentários.

Comentários do Facebook